Hugging Face Transformers 는 자연어 처리(NLP, 인간이 사용하는 자연스러운 언어를 컴퓨터가 이해 하도록 연구하는 인공지능의 한 분야) 및 딥러닝을 위한 강력한 라이브러리로, 다양한 사전 학습된 모델과 이를 손쉽게 활용할 수 있는 도구를 제공하며 사용하기 위해선 먼저 Python이 설치되어 있어야 한다.

콘텐츠

Python 설치

Hugging Face Transformers 사용을 위한 Python 설치 방법은 Python 쉽고 간단하게 프로그래밍 시작하기 포스팅에 상세하게 정리되어 있으며 요약하면 다음과 같다.

- Download Python | Python.org 접속

- Python 다운로드 및 설치 (최소 3.8 버전 이상)

- 설치 후 cmd 창에서 python –version 입력 후 버전이 정상 출력 되는지 확인

python –version 때 버전이 정상적으로 출력 되지 않으면 환경 변수 설정이나 재 설치를 진행한다.

Python 가상 환경 생성

Hugging Face Transformers 설치 전 가상 환경을 만드는 이유

Python 가상 환경은 3.3 버전부터 내장된 기능으로 프로젝트 별 독립 된 가상 환경을 만들기 위한 것이다. 가상 환경을 만드는 이유는 Python 프로젝트 마다 독립성을 유지하고 의존성 충돌을 방지하여 관리하기가 수월해 진다.

만약 가상 환경을 만든다면 잘못된 패키지 등을 설치 등을 통해 전역 환경(global environment) 등을 오염을 방지할 수 있으며 새로운 프로젝트를 깔끔한 상태로 다시 시작할 수 있다.

가상 환경 생성

* 아래의 내용은 Windows OS 환경 기준으로 작성되었다.

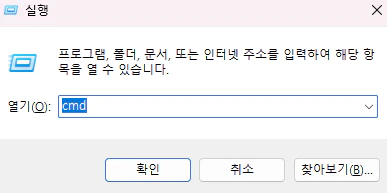

1. CMD 또는 터미널 열기 (키보드 의 win + R 키 입력 시 나오는 실행 창에 cmd 를 입력하면 열 수 있다.)

2. 작업을 할 디렉토리(폴더)의 경로로 이동

cd C:\디렉토리3. 가상 환경 생성

python -m venv venv- venv 는 python 3.3 부터 내장된 가상 환경 모듈이다.

- 위의 명령어는 venv 모듈을 이용해 venv 라는 이름의 가상 환경을 만드는 것이다.

- 명령어 끝에 가상 환경의 이름인 venv 는 변경되어도 상관 없지만 관행 상 venv 로 자주 만든다.

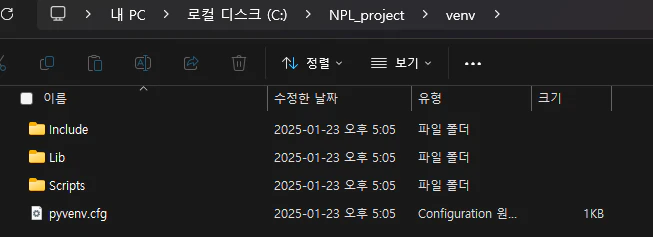

4. 프로젝트 경로 및 venv 디렉토리가 생성 되었는지 확인

5. 다음 명령어로 가상 환경 활성화

venv\Scripts\activate정상적으로 수행이 되었다면 명령줄 프롬프트 앞에 (venv) 가 붙게 된다.

Hugging Face Transformers 라이브러리 설치

Hugging Face 에서 제공하는 자연어 처리(NLP) 라이브러리인 transformers 와 datasets 모듈은 pip 를 이용해 설치가 가능하다.

해당 라이브러리는 python 기반의 패키지 형태로 제공 되며 위의 방법으로 가상 환경을 활성화한 상태로 다음 명령어를 통해 설치한다.

pip install transformers

pip install datasets- Transformers: 사전 훈련 된 딥러닝 모델을 로드 한 후 자연어 처리 작업(텍스트 분류, 번역, 요약 등)을 수행하는데 사용된다.

- Datasets: 자연어 처리, 머신 러닝 등의 작업에서 사용할 수 있는 정형화된 데이터 모음인 데이터셋(DataSet)을 빠르게 로드하고 변환, 처리 할 수 있게 해준다.

Pytorch 설치

위의 두 라이브러리를 설치 했으면 머신러닝(ML) 및 딥러닝(DL) 모델을 구축, 훈련하는 프레임워크를 하나 설치해야 한다.

주로 transformers 에 사용 되는 프레임워크는 PyTorch, TensorFlow, Flax 세가지 이며 ChatGPT 가 권장하는 프레임워크인 PyTorch 를 설치했다.

Pytorch 는 Meta(과거 페이스북)에서 개발한 오픈소스 딥러닝 프레임워크다. Pythonic(파이썬스러운 이란 뜻)한 인터페이스를 제공하여 직관적이고 사용하기 쉽단 장점이 있으며 동적 연산 그래프(Dynamic Computational Graph)을 사용하므로 런타임에서 모델 구조 변경이 가능하다.

특히 GPU 가속 지원(CUDA 활용)을 지원해 딥러닝 연산 속도가 느린 CPU 를 대신하여 그래픽 카드를 통해 효과적으로 연산할 수 있다.

Pytorch 는 다음 명령어로 총 세가지 라이브러리를 설치하여 사용한다.

pip install torch torchvision torchaudio- torch: Pytorch 의 핵심 라이브러리로 딥러닝 모델 구축, 텐서 연산, 자동 미분 등을 지원

- torchvision: 컴퓨터 비전(이미지 데이터셋, 변환 등) 용 라이브러리

- torchaudio: 오디오 데이터(음성 신호 등) 용 라이브러리

명령어 입력 시 다음과 같이 표시되며 설치가 진행된다.

설치 후 확인 방법

코드를 위한 파이썬 파일 (test.py 등) 을 만들고 아래의 코드를 통해 패키지의 버전을 출력 해 보면 정상 설치 여부를 알 수 있다.

import transformers

import datasets

print(transformers.__version__) # 설치된 버전 출력

print(datasets.__version__) # 설치된 버전 출력만약 모델 관련 프레임워크가 설치되어 있지 않다면 None of PyTorch, TensorFlow >= 2.0, or Flax have been found. Models won’t be available and only tokenizers, configuration and file/data utilities can be used. 와 같은 메시지가 표시된다.

transformers 간단 사용 튜토리얼

from transformers import pipeline

generator = pipeline("text-generation", model="gpt2")

result = generator("Hugging Face is", max_length=30, num_return_sequences=1)

print(result)위의 코드는 사전 훈련된 AI 모델인 GPT-2 모델을 활용해서 텍스트를 자동으로 생성하는 단순한 예제이다.

위의 코드가 실행 되면 ‘Hugging Face is not going to help you lose weight in the short term. So, while making your first few days a breeze, make a plan’ 이라 출력이 되었는데, Huggin Face is 라는 문장 뒤에 AI 모델이 직접 새로운 문장을 이어 붙여준 것이다.